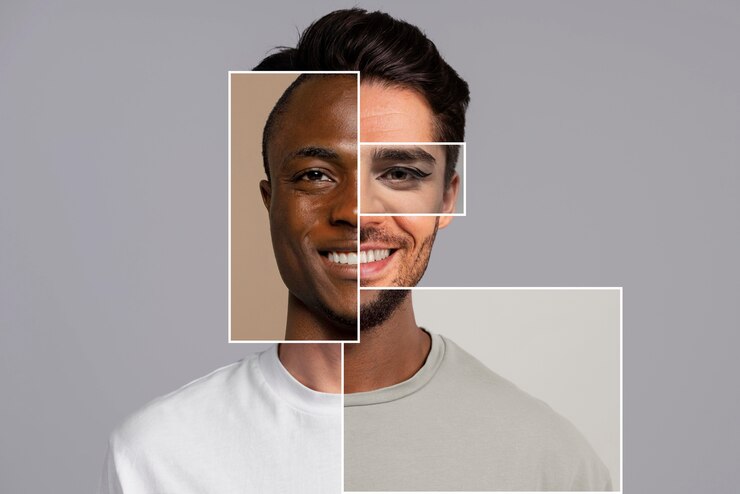

Os esquemas de deepfakes entraram na consciência dos consumidores e das empresas devido à sua crescente sofisticação. Segundo a Check Point, a capacidade de imitar um humano com uma qualidade superior é agora mais possível do que nunca. Isto deve-se ao facto de o acesso às ferramentas de IA utilizadas para criar deepfakes ter sido democratizado, toda agente consegue a ceder a estas ferramentas, isto juntamente com barreiras de baixo custo à entrada – significa que as falsificações convincentes podem ser implementadas à escala.

A nossa investigação revelou que, no espaço de 30 segundos ou menos após uma conversa, qualquer pessoa com as ferramentas de IA necessárias pode criar um deepfake a partir da uma voz para qualquer tema que deseje, durante o tempo que quiser, praticamente sem custos. É um fator de mudança e o mesmo se aplica agora ao vídeo.

De acordo com um relatório da Sumsub Research realizado no ano passado, os incidentes globais de deepfake aumentaram dez vezes de 2022 a 2023, com a América do Norte a registar o maior crescimento de ataques de deepfake de 1740%.

Para as empresas, uma das principais preocupações é saber se um executivo pode ser objeto de um deepfake convincente – ou se um funcionário “privilegiado” pode ser enganado por isso. No início deste ano, um funcionário do setor financeiro atento de Hong Kong foi levado a aprovar um pagamento de 25 milhões de dólares através de uma elaborada videoconferência com um deepfake do diretor financeiro da sua empresa. Em resposta a um pedido de transferência de dinheiro, o funcionário solicitou uma reunião via Zoom e só enviou o dinheiro depois de falar com quem pensava ser o diretor financeiro e vários outros colegas na mesma chamada, todos eles deepfakes. O caso mostrou a evolução da tecnologia e o seu potencial como um novo vetor de ameaça para as burlas comerciais.

Os impactos comerciais significativos associados à utilização maliciosa de deepfakes levam as pessoas e as empresas a perguntar o que podem fazer para se protegerem a si próprias e às suas operações. Como é que podem saber se a pessoa que está do outro lado de uma videoconferência é real e não uma criação da IA?

A um nível elevado, exige que as pessoas estejam vigilantes e efetuem algumas verificações de senso comum. Em todas as situações, as pessoas tendem a ponderar o que estão a ver e a fazer determinadas avaliações e juízos de risco. Da mesma forma que as pessoas verificam atualmente a veracidade de uma mensagem de correio eletrónico ou do seu conteúdo – verificando a identificação do remetente, passando por cima de um URL ou de um ficheiro anexado, examinando o estilo e a gramática – podem beneficiar da aplicação do mesmo tipo de abordagem às reuniões de videoconferência.

Esta triangulação de indícios e de fatores de risco é uma espécie de “autenticação multifatorial” que temos agora de realizar de forma mais consciente nos locais de trabalho.

Dicas e Truques

Assim, quais são algumas das verificações que os funcionários podem efetuar atualmente para detetar um deepfake ou para se alertarem para uma tentativa de fraude mais sofisticada que utilize a tecnologia deepfake?

A primeira é efetuar uma verificação rápida da “vivacidade” – pedir à pessoa do outro lado do vídeo para virar a cabeça de um lado para o outro. Isto é eficaz atualmente porque as ferramentas de IA generativas utilizadas para produzir deepfakes não criam uma imagem tridimensional ou de 360 graus da pessoa, apenas conseguem produzir imagens planas viradas para a frente. As vistas laterais da cabeça e do rosto não são apresentadas corretamente. Por isso, se os funcionários suspeitarem, devem pedir à pessoa para se virar para a esquerda ou para a direita e, se o rosto desaparecer, desligar.

Da mesma forma, outros comportamentos humanos naturais frequentemente observados numa videoconferência – alguém que se levanta e coça ou toca na cabeça, por exemplo – também não serão apresentados corretamente com um deepfake.

Isto é eficaz atualmente, mas pode já não ser amanhã. O ritmo acelerado do desenvolvimento da IA generativa significa que as ferramentas irão melhorar a criação de imagens mais realistas das pessoas e dos seus maneirismos, o que poderá tornar a verificação da vivacidade mais difícil ao longo do tempo.

Mas os funcionários podem ser capazes de detetar pistas adicionais de que uma videoconferência com um executivo não é o que parece.

Uma verificação útil quando se recebe uma chamada para uma videoconferência – ou quando se entra numa chamada com vários participantes – é verificar se os participantes estão a utilizar uma versão licenciada da empresa desse software. Isso é muitas vezes óbvio, porque as empresas utilizam um “URL da vaidade” – companyname.videoplatform.com – para mostrar de onde estão a telefonar. A confiança pode ser reforçada comunicando antecipadamente – através de um método diferente, como o chat ou o email – a forma como o utilizador e as outras pessoas vão participar na videoconferência. Se souber de antemão que vai receber um convite de videoconferência de um determinado domínio da empresa, é mais um “fator” que pode ser tido em conta para determinar se aceita ou não a reunião. Se a reunião for iniciada a partir de uma conta pessoal, ou se alguém se juntar inesperadamente e sem explicação a partir de uma conta pessoal, pode ser um sinal de alerta – e justificar, pelo menos, uma ou duas perguntas ou algumas verificações adicionais.

Uma terceira estratégia útil consiste em acordar palavras de código internas que têm de ser verificadas antes de determinadas ações – como uma transferência de dinheiro – serem executadas. No caso do trabalhador de Hong Kong, isto significaria enviar uma mensagem ao diretor financeiro com quem pensavam estar a falar através de um canal completamente diferente e perguntar: “Qual é a palavra?”. A resposta que receberiam dir-lhes-ia rapidamente se o “CFO” – e o pedido que estava a ser feito – era genuíno ou não.

Os funcionários devem continuar a ser cautelosos e preocupados, utilizar todas as dicas à sua disposição e manter-se atualizados com a evolução da tecnologia de IA, para lidar com a ameaça de se depararem com um deepfake. Os seus esforços podem ser competentemente apoiados pelas organizações que implementam soluções de cibersegurança, incluindo proteções de correio eletrónico robustas, que podem detetar e impedir que muitos convites de reunião maliciosos sejam entregues nas caixas de entrada. Dada a realidade da ameaça, é importante dispor de proteções completas.